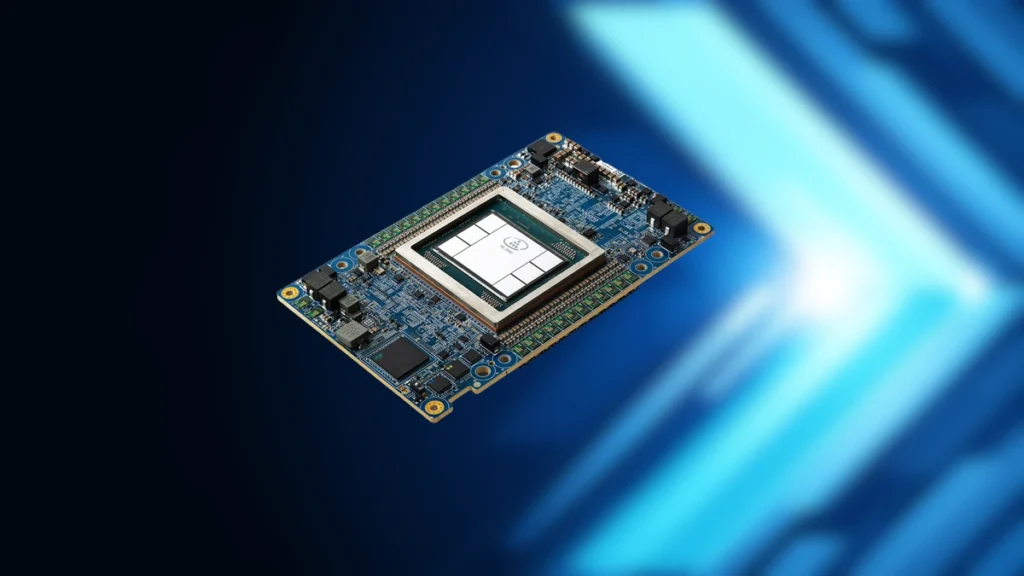

Intel i Habana opublikowały dziś benchmarki treningowe MLPerf, które zawierają kilka bardzo interesujących wyników. Układ Gaudi2 Intela jest obecnie jedyną alternatywą dla akceleratorów graficznych NVIDIA do trenowania LLM.

ChatGPT jest prawdopodobnie najbardziej przełomową technologią ostatnich lat i jasne jest, że przyszłością jest LLM. ChatGPT (darmowy) oparty jest na modelu GPT 3.5, który z kolei bazuje na modelu GPT-3. ChatGPT 4 bazuje na GPT-4, ale informacje na jego temat są bardzo skąpe i nie istnieje dla niego żaden benchmark. Tak więc trenowanie GPT-3 do wystarczającego poziomu dokładności (lub redukcji strat) byłoby najbardziej odpowiednim benchmarkiem przy określaniu, czego użyć jako treningowego CPU/GPU. NVIDIA dominuje na tym polu używając swoich procesorów graficznych Hopper, ale w końcu pojawiła się alternatywa: Intel Gaudi2.

Gaudi2 uzyskuje podobny wynik w stosunku cena/wydajność do NVIDIA A100 i chce pokonać H100 do września w obliczeniach FP8

Intel twierdzi, że ma lepszy stosunek ceny do wydajności niż A100 (FP16) już teraz i zamierza pokonać NVIDIA H100 (FP8) do września. Jest to dość ambitny cel, ale firma ma testy porównawcze, które to potwierdzają. Oto krótki przegląd wyników:

- Gaudi2 zapewnił imponujący time-to-train na GPT-31: 311 minut na 384 akceleratorach

- Prawie liniowe 95% skalowanie z 256 do 384 akceleratorów w modelu GPT-3

- Doskonałe wyniki szkolenia w zakresie wizji komputerowej – ResNet-50 8 akceleratorów i Unet3D 8 akceleratorów, oraz modeli przetwarzania języka naturalnego – BERT 8 i 64 akceleratory

- Wzrost wydajności o odpowiednio 10% i 4% dla modeli BERT i ResNet w porównaniu do wyników z listopada, co świadczy o rosnącej dojrzałości oprogramowania Gaudi2

- Wyniki Gaudi2 zostały przedstawione „out of the box”, co oznacza, że klienci mogą osiągnąć porównywalne wyniki wydajności już podczas jego wdrażania

Odnosząc się do powyższego, NVIDIA może trenować GPT-31 w 45 minut, ale także wykorzystuje znacznie więcej procesorów graficznych. Ostatecznie jedynym sposobem na dokonanie właściwego porównania byłoby wykorzystanie TCO i poznanie dokładnych kosztów oraz ograniczeń TDP / ciepła. Wszystko to może być jednak nieistotne, ponieważ popyt znacznie przewyższa podaż w tej dziedzinie. Podczas gdy akceleratory graficzne NVIDIA będą sprzedawać się jak ciepłe bułeczki, ich podaż jest ograniczona, a rynek będzie głodny krzemu, który może trenować LLM – i właśnie tam Gaudi2 Intela może uratować sytuację i zapewnić układy spragnionym ich klientom.

Intel podzielił się również wynikami dla swojej klasy procesorów Xeon Platinum. Są one obecnie używane w najlepiej działającym procesie MLPerf do szkolenia LLM, które trwa nieco ponad 10 godzin dla GPT-3. Oto najważniejsze wyniki:

- W zamkniętym podziale Xeony 4. generacji były w stanie wytrenować modele BERT i ResNet-50 odpowiednio w mniej niż 50 minut (47,93 min.) i mniej niż 90 minut (88,17 min.)

- W przypadku BERT w otwartym podziale wyniki pokazują, że Xeon był w stanie wytrenować model w około 30 minut (31,06 min.) przy skalowaniu do 16 węzłów

- W przypadku większego modelu RetinaNet, Xeon był w stanie osiągnąć czas 232 minut na 16 węzłach, pozwalając klientom na elastyczność wykorzystania cykli Xeon poza szczytem do trenowania swoich modeli w ciągu poranka, lunchu lub nocy

- Xeon czwartej generacji z Intel Advanced Matrix Extensions (Intel AMX) zapewnia znaczną poprawę wydajności już out of the box, która obejmuje wiele frameworków, kompleksowe narzędzia do analizy danych i szeroki ekosystem inteligentnych rozwiązań

Najnowsze Komentarze