NVIDIA, SK hynix i TSMC zawiązują nowy sojusz w celu przyspieszenia postępu GPU oraz HBM4 na potrzeby ciągle rozwijającej się sztucznej inteligencji.

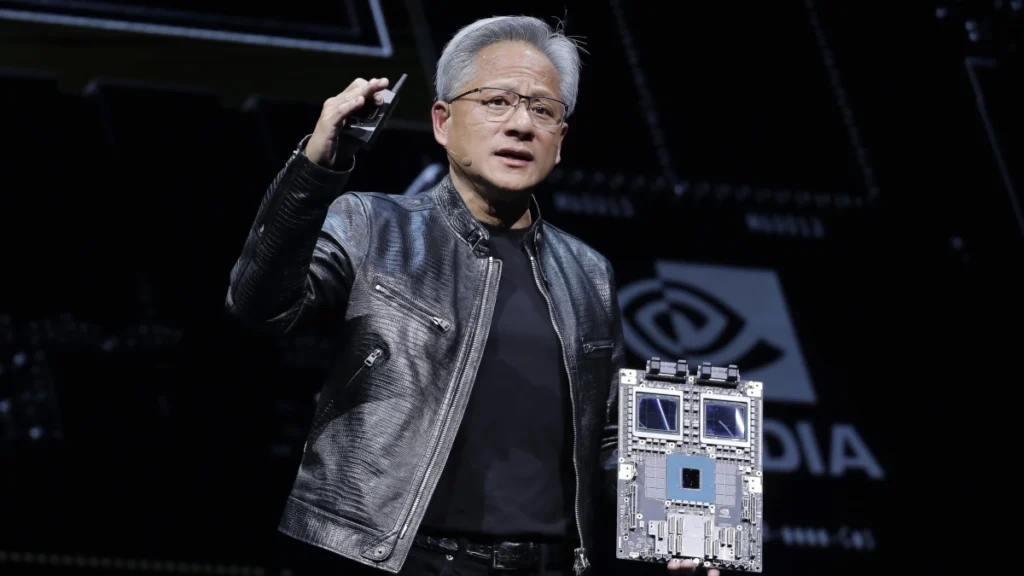

Chociaż informacja nie została jeszcze oficjalnie potwierdzona, to współpraca między trójką firm jest niemal pewna. Zwłaszcza, że ogłoszenie zacieśnienia współpracy jest już zaplanowane i zostanie przedstawione do wiadomości publicznej podczas targów SEMICON Taiwan 2024 – największej imprezie dla branży półprzewodnikowej. Swoją obecność potwierdzili już prezesi NVIDII i SK hynix – Jensen Huang oraz Kim Joo-sun.

Pamięci HBM4 mogą zrewolucjonizować branżę AI

Podczas tajwańskiego wydarzenia szczególny nacisk ma być położony na pamięci HMB nowej generacji, czyli układy HBM4. Zaprojektowane je specjalnie z myślą o najwydajniejszych akceleratorach AI oraz HPC dla centrów danych. Nie ma co oczekiwać, że pojawią się w sprzęcie przeznaczonym dla zwykłych użytkowników i graczy.

Pamięci HBM4 zaoferują do 16 warstw 32 Gb, co zaowocuje łączną pojemnością do 64 GB. Jeśli weźmiemy pod uwagę, że standardowy akcelerator lub karta graficzna posiada zwykle cztery układy pamięci, to da nam to potencjalnie aż 256 GB pamięci VRAM o szczytowej przepustowości 6,56 TB/s przy wykorzystaniu 8192-bitowej magistrali.

SK hynix jest jedną z pierwszych firm, które wdrożyły „wielofunkcyjną pamięć HBM”. W nowoczesnej implementacji zaawansowane pamięci są połączone z różnymi matrycami, aby uzyskać odpowiednią wydajność. W tym celu wykorzystuje się technologię CoWoS. Nie jest to jednak najoptymalniejsze rozwiązanie i znacznie lepsze byłoby scalenie ich w jedno. Taki jest właśnie cel tego sojuszu, w którym to Koreańczycy odpowiadają za pamięci HBM, Tajwańczycy za półprzewodniki natomiast Amerykanie za projekt ostatecznego produktu.

Najnowsze Komentarze